ย่างเข้าสู่ปี 2569 เชื่อว่าเทคโนโลยี Generative AI จะก้าวล้ำขึ้นไปอีกขั้นจากปีที่ผ่านมา แต่เทคโนโลยีที่ใช้สำหรับสร้างประโยชน์เหล่านี้ อาจถูกนำมาใช้โดยมิจฉาชีพ จนกลายเป็นดาบสองคม เพราะตลอดปี 2568 มิจฉาชีพไม่ได้หยุดแค่การโทรศัพท์หลอกโอนเงินแบบเดิม ๆ แต่เริ่มหันมาใช้ “AI Voice Cloning” ในการลอกเลียนแบบเสียงเพื่อหลอกเหยื่อ ขณะที่เดือน พ.ย. 68 ที่ผ่านมา ก็มีการจับกุมแก๊งสแกมเมอร์ชาวจีน ที่ใช้ AI หลอก AI เพื่อข้ามผ่านระบบรักษาความปลอดภัยของธนาคารที่เรียกว่า Biometric Verification ออกมาให้เห็นกันแล้ว ซึ่งแม้จะยังไม่ได้ถูกนำมาใช้หลอกคนไทย แต่เชื่อว่าเทคโนโลยีเหล่านี้ อาจจะถูกนำมาใช้อย่างแน่นอนในปี 2569

AI ของมิจฉาชีพในปี 68 เป็นอย่างไร ?

พ.ต.อ. เนติ วงษ์กุหลาบ รองผู้บังคับการ กองบังคับการปราบปรามการกระทำความผิดเกี่ยวกับอาชญากรรมทางเทคโนโลยี กองบัญชาการตำรวจสอบสวนกลาง (CIB) เปิดเผยกับ Thai PBS Verify ว่า กลลวงของมิจฉาชีพในปี 2568 ที่พบว่ามีการใช้ AI เข้ามาช่วยในการหลอกลวงในขณะนี้คือ การปลอมเสียงด้วย AI ที่พบว่ามีการใช้มาแล้วหลายเดือน โดยมักใช้กลลวงว่าเปลี่ยนเบอร์โทรศัพท์ ให้เหยื่อลบเบอร์เก่าทิ้ง และให้เหยื่อบันทึกเบอร์ใหม่ที่คนร้ายโทรเข้าไปแทน จากนั้นคนร้ายจะพูดคุยต่าง ๆ นานา โดยส่วนใหญ่จะวางสายก่อน และปล่อยให้ระยะเวลาผ่านไป 1-2 วัน จึงค่อยติดต่อรอบ 2 ซึ่งในครั้งนี้จึงจะเริ่มสร้างสตอรี่ขึ้นมาเพื่อหลอกเหยื่อ

พ.ต.อ. เนติ วงษ์กุหลาบ รองผู้บังคับการ กองบังคับการปราบปรามการกระทำความผิดเกี่ยวกับอาชญากรรมทางเทคโนโลยี กองบัญชาการตำรวจสอบสวนกลาง (CIB)

เรื่องอะไรบ้างที่คนร้ายใช้หลอกเหยื่อปี 68 ?

พ.ต.อ. เนติ ระบุว่า เรื่องที่คนร้ายใช้หลอกเหยื่อในปี 2568 พบว่า มีหลายรูปแบบ แต่ทุกรูปแบบจะเริ่มต้นด้วยการบอกให้เหยื่อ “ลบเบอร์โทรศัพท์เก่าของคนที่มิจฉาชีพแอบอ้างทิ้งก่อน” โดยอ้างว่าได้ “เปลี่ยนเบอร์โทรศัพท์ใหม่” จากนั้นจะปล่อยระยะเวลาให้ผ่านไปราวหนึ่งถึงสองวัน ก่อนที่คนร้ายจะติดต่อกลับมาอีกครั้ง ซึ่งจากพฤติการณ์ที่พบ คนร้ายมักจะไม่ค่อยหลอกเหยื่อในวันแรกในทันที แต่จะปล่อยระยะเวลาไว้สักพัก จากนั้นจะติดต่อกลับมาพร้อมกับปัญหาความเดือดร้อน โดยเฉพาะเรื่องเงิน เช่น

- อ้างว่าซื้อของแล้วไม่สามารถติดต่อภรรยาได้ ขอให้เหยื่อช่วยโอนเงินเพื่อจ่ายให้กับร้านค้า หากติดต่อญาติหรือภรรยาได้แล้ว จะโอนเงินคืนทันที

- อ้างว่าเป็นลูกของเหยื่อ หรือพ่อแม่ของเหยื่อ ติดต่อเพื่อขอให้โอนเงินให้

ทั้งสองกรณีจะหลอกเงินเหยื่อตั้งแต่หลักหมื่นไปจนถึงหลักแสน หรือมากกว่านั้นหากสามารถที่จะหลอกได้

สังเกตอย่างไรคนรู้จักหรือคนร้าย ?

สำหรับข้อสังเกตว่า เบอร์โทรศัพท์ที่โทรหาเราเป็นมิจฉาชีพหรือไม่นั้น สามารถตรวจสอบได้ดังนี้

- หากเป็นคนรู้จักที่มีเบอร์โทรศัพท์อยู่แล้ว แม้สายที่โทรมานั้นจะมีเสียงเหมือนเพื่อน พ่อ แม่ พี่น้อง ลูก หลาน แต่หากเป็นเบอร์โทรศัพท์ที่ไม่เคยพบหรือเป็นเบอร์แปลก และบอกกับเราว่าเปิดเบอร์ใหม่ ให้ลบเบอร์เก่า ให้สงสัยไว้ก่อนว่าเป็นมิจฉาชีพ

- ให้ขอตัววางสายเบอร์แปลกนั้น ไม่ว่าจะเป็นลูก หรือญาติ พี่น้อง หรือคนที่เรารู้จักทันที จากนั้นจึงค่อยโทรกลับไปยังเบอร์เก่าที่เรามีอยู่ และสอบถามว่า ได้โทรหาเราหรือไม่ ซึ่งทั้งสองวิธีนี้ถือเป็นการป้องกันมิจฉาชีพที่ดีและง่ายที่สุด

ตัวอย่างคนร้ายหลอกเป็นคนรู้จัก

ภัยออนไลน์ในปี 2569

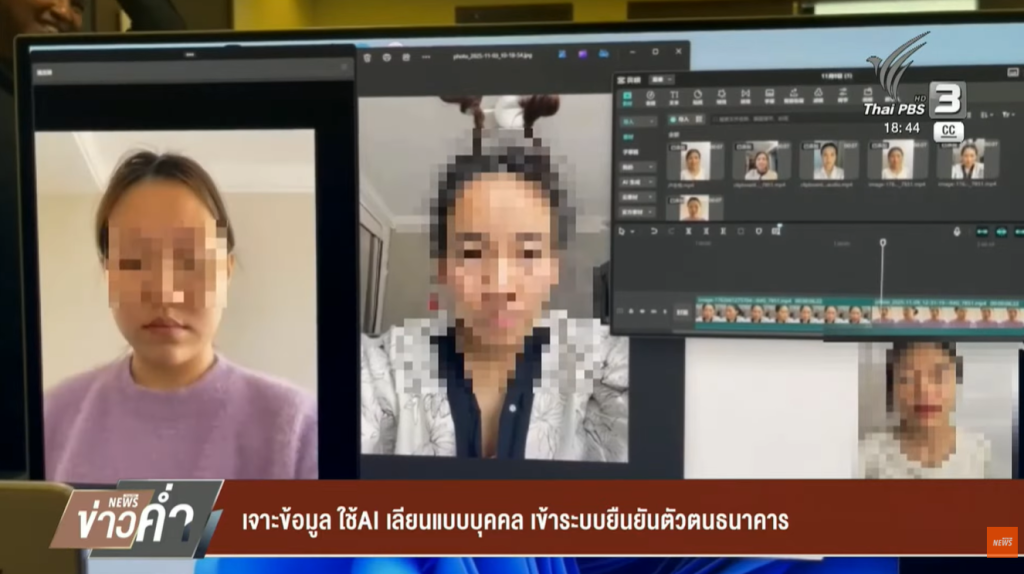

วิวัฒนาการใหม่จาก Deepfake สู่การเจาะระบบยืนยันตัวตน

ในอดีตเราอาจเคยเห็นการใช้เสียง AI Deepfake เพื่อปลอมเป็นคนรู้จักมาขอยืมเงิน แต่ปัจจุบันมีความพยายามในการใช้ AI ใบหน้าเสมือน ที่มีความละเอียดสูง จนสามารถขยับเขยื้อนตามคำสั่งของระบบยืนยันตัวตนธนาคารได้ เช่น การกะพริบตา การหันซ้าย-ขวา หรือการอ้าปาก ซึ่งเป็นด่านรักษาความปลอดภัยสำคัญเมื่อต้องโอนเงินจำนวนมาก ซึ่งกรณีล่าสุดคือการจับกุมแก๊งสแกมเมอร์ชาวจีนใช้ AI หลอก AI เพื่อข้ามผ่านระบบรักษาความปลอดภัยของธนาคาร เมื่อเดือน พ.ย. 68

แก๊งสแกมเมอร์ชาวจีนใช้ AI หลอก AI เพื่อข้ามผ่านระบบรักษาความปลอดภัยของธนาคาร

แม้การจับกุมในครั้งนี้จะไม่ใช่การสร้าง AI Deepfake เพื่อมาใช้หลอกลวงคนไทย แต่เชื่อว่าเทคโนโลยีดังกล่าว มีความเสี่ยงสูงที่จะถูกนำมาหลอกลวงคนไทยในปี 2569 นี้ ซึ่ง Thai PBS Verify ตรวจสอบพบว่า เครื่องมือเหล่านี้ถูกพัฒนาให้แนบเนียนขึ้น โดยมิจฉาชีพจะหา “วัตถุดิบ” จาก

- ภาพถ่ายใบหน้าตรงที่เจ้าตัวเคยโพสต์ในโซเชียลมีเดีย

- วิดีโอหรือคลิปสั้นที่เห็นใบหน้าหลายมุม

- ข้อมูลส่วนตัวจากฐานข้อมูลที่รั่วไหล เพื่อนำไปสู่การปลอมแปลงใบสมัครหรือการรีเซ็ตรหัสผ่าน

ตัวอย่างคลิป AI หลอก AI

ทำไมมุก ญาติ-คนรู้จัก ยังใช้หลอกเหยื่อได้เสมอ ?

นายวรภัทร ศิริกีรตยานนท์ นักอาชญาวิทยาอิสระ ให้ความคิดเห็นถึงสาเหตุที่การอ้างเป็น ญาติ-คนรู้จัก ยังสามารถใช้หลอกลวงได้เสมอว่า ด้วยสภาพแวดล้อมปัจจุบัน ที่หลาย ๆ คนแทบจะไม่ได้ทำงานในภูมิลำเนาเดิมแบบ 100% เพราะบางคนต้องย้ายถิ่นฐานไปทำงานในจังหวัดหัวเมืองใหญ่ หรือมาทำงานในกรุงเทพฯ ที่เป็นเมืองหลวงหลัก หรือแม้กระทั่งคนที่อาจจะไปทำงานที่ต่างประเทศ ประกอบกับความที่สภาพเศรษฐกิจ สภาพแวดล้อมต่าง ๆ บีบให้เราต้องทำงานในต่างพื้นที่กัน จึงทำให้การอยู่ด้วยกันของคนในครอบครัว ที่เดิมทีเคยอยู่กันเป็นครอบครัวใหญ่ มีจุดที่เรียกว่าช่องว่างเกิดขึ้น จึงทำให้คนร้ายอาศัยรอยแยกดังกล่าว มาเป็นมาเป็นจุดเด็ดในการก่อเหตุ ด้วยการอ้างบุคคลในครอบครัวหรือ เพื่อนฝูงที่เคยสนิทกัน มาเป็นปัจจัยหลักในการใช้หลอกลวงเหยื่อ

นายวรภัทร พึ่งพงศ์ นักวิชาการอิสระ ด้านอาชญาวิทยาและเหยื่อวิทยา

ผมก็ยังเชื่ออยู่ว่า รูปแบบนี้ยังคงมีประสิทธิภาพในระดับหนึ่ง ที่มิจฉาชีพจะยังยึดเป็นแก่นหลักในการเข้าถึงเหยื่อรายใหม่ ๆ แต่ในอนาคต มันอาจจะมีอะไรที่แยกแยะได้ยาก เห็นได้จากการที่สแกมเมอร์มีการใช้ Deepfake ในการปลอมหน้า ปลอมเสียง หรือวิดีโอคอล เชื่อว่ารูปแบบนี้จะยังคงอยู่ แต่อาจจะมีเทคโนโลยีหรือซอฟต์แวร์อะไรที่มันทำให้ดูมีความเนียนมากขึ้น

ทั้งนี้เห็นได้จากในปี 2568 ที่ผ่านมา ที่มีข่าวการพัฒนาซอฟต์แวร์ที่สร้างภาพได้อย่างแนบเนียนมากขึ้น ซึ่งเทคโนโลยีเหล่านี้อาจจะถูกนำมาใช้ หลอกลวงมากขึ้น แต่อย่างไรก็ตามเชื่อว่า เรื่องของการปลอมแปลงเสียงแบบไม่ได้เจอหน้า ไม่ให้เขาเห็นจุดพิกเซลที่ผิดปกติ ก็จะยังคงมีอยู่ เพราะถือเป็นอีกหนึ่งวิธีที่มีประสิทธิภาพ ทั้งในแง่ของการลงทุนที่ใช้การลงทุนที่น้อย และในแง่ของจำนวน ที่สามารถหลอกได้ปริมาณมากในระยะเวลาสั้น ๆ โดยไม่ต้องใช้เทคโนโลยีที่ซับซ้อนให้เสียเวลา ซึ่งเชื่อว่าจะยังคงเป็นหนึ่งวิธีที่ถูกนำมาใช้มากที่สุดในปี 2569

3 จุดจับสังเกต “อัตลักษณ์ AI” ที่คุณต้องระวังมีอะไรบ้าง ?

แม้ AI จะดูสมจริงมาก แต่หากสังเกตอย่างละเอียดในระหว่างการวิดีโอคอล หรือการยืนยันตัวตน จะพบจุดผิดปกติดังนี้:

- การเคลื่อนไหวที่ขอบใบหน้า: หากสังเกตบริเวณไรผมหรือรอยต่อระหว่างใบหน้ากับลำคอ จะเห็นความเบลอหรือการกะพริบ (Glitch) เมื่อมีการขยับเร็ว ๆ

- มิติของดวงตาและแสงสะท้อน: แสงสะท้อนในดวงตาของ AI มักจะไม่สัมพันธ์กับทิศทางแสงจริงในสถานที่นั้น ๆ หรือการกะพริบตาที่ดูแข็งทื่อไม่เป็นธรรมชาติ

- ความเหลื่อมของเสียง (Sync): เสียงพูดกับจังหวะการขยับริมฝีปากอาจมีความล่าช้า (Delay) หรือน้ำเสียงมีโทนแบนราบ (Monotone) ขาดอารมณ์ความรู้สึกแบบมนุษย์

วิธีป้องกัน: ปิดประตูไม่ให้มิจฉาชีพขโมยอัตลักษณ์

กองบัญชาการตำรวจสืบสวนสอบสวนอาชญากรรมทางเทคโนโลยี (บช.สอท.) และผู้เชี่ยวชาญด้านไซเบอร์แนะนำข้อปฏิบัติเพื่อความปลอดภัย ดังนี้:

- ตั้งรหัสลับเฉพาะครอบครัว: เมื่อได้รับสายวิดีโอคอลที่น่าสงสัย หรืออ้างว่าเป็นคนใกล้ชิดขอยืมเงิน ให้ถาม “รหัสลับ” หรือ “เรื่องที่มีแค่เราสองคนที่รู้” เพื่อยืนยันตัวตน

- เลี่ยงการลงภาพหน้าตรงความละเอียดสูง: การโพสต์ภาพเซลฟี่ที่ชัดเกินไปในพื้นที่สาธารณะ เป็นการยื่น “ต้นแบบ” ให้ AI นำไปประมวลผลได้ง่ายขึ้น

- สังเกตพฤติกรรมการเรียกเก็บข้อมูล: ธนาคารไม่มีนโยบายส่งลิงก์เพื่อให้ลูกค้าอัปโหลดวิดีโอใบหน้าหรือข้อมูล Biometric ผ่านแอปพลิเคชันอื่นที่ไม่ใช่แอปฯ ทางการของธนาคาร

- ใช้การยืนยันตัวตนหลายชั้น (MFA): นอกจากใบหน้า ควรเปิดใช้งานการยืนยันตัวตนผ่านช่องทางอื่นควบคู่ไปด้วย เช่น แอปฯ Authenticator

เทคโนโลยีการยืนยันตัวตนด้วยใบหน้าของธนาคารในประเทศไทย ปัจจุบันมีการพัฒนาระบบ Liveness Detection เพื่อป้องกันภาพถ่ายหรือวิดีโอหลอกลวง อย่างไรก็ตาม มิจฉาชีพก็กำลังพัฒนา AI เพื่อมาต่อสู้กับระบบนี้เช่นกัน

ดังนั้นสิ่งสำคัญในปี 2569 ยังคงเป็นเรื่องของ “สติ” และ “ความไม่ใจเร็ว” ที่ยังคงเป็นเกราะป้องกันที่ดีที่สุด โดยเฉพาะเมื่อต้องเผชิญหน้ากับมิจฉาชีพที่พัฒนาวิธีการหลอกลวงอยู่ตลอดเวลาเช่นปัจจุบัน